Interfacce per il controllo espressivo di processi musicali

Giovanni Costantini1,2, Massimiliano Todisco1,3

1 Department of Electronic Engineering, University of Rome “Tor Vergata”, Rome, Italy

2 IDASC Institute of Acoustics and Sensors “Orso Mario Corbino”, Rome, Italy

3 Fondazione “Ugo Bordoni”, Rome, Italy

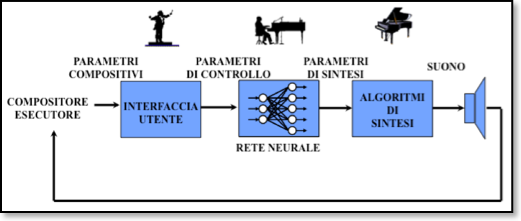

Con il termine ‘processo musicale’ si intende un complesso algoritmo di sintesi/elaborazione del suono sul quale sia possibile un controllo ad alto livello. Tale controllo deve essere effettuato ‘in tempo reale’, cioè mentre si ascolta il suono prodotto dal processo stesso. Essendo molto spesso coinvolti un gran numero di parametri di sintesi/elaborazione, è necessario utilizzare interfacce di controllo che consentano di guidarli tutti contemporaneamente in modo semplice ed espressivo dal punto di vista musicale.

La situazione è la stessa che si ha nella musica tradizionale, dove un direttore d’orchestra, con pochi gesti, deve essere in grado di guidare un’esecuzione musicale complessa (Fig. 1).

Fig. 1 – Analogia con l’esecuzione musicale tradizionale

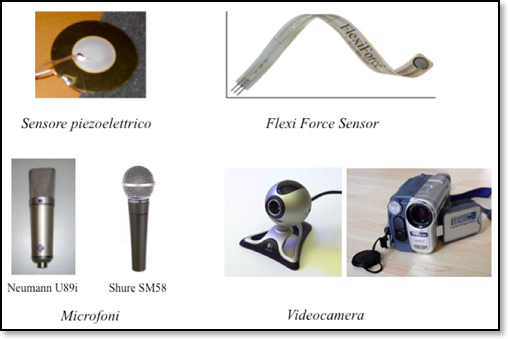

Le interfacce di controllo sono realizzate mediante sensori di vario tipo: microfoni, videocamere, sensori a pressione, a flessione, piezoelettrici, ecc… (Fig. 2) e possono inglobare sistemi complessi di mapping come reti neurali.

Fig. 2 – Esempi di sensori

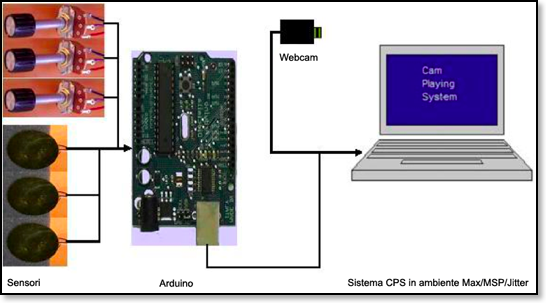

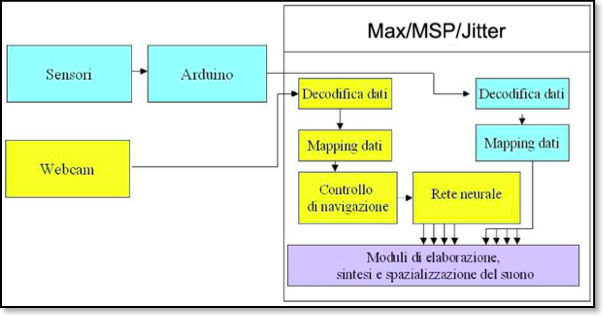

Un esempio di interfaccia comprendente sensori di questo tipo è mostrata in Fig. 3 ed un possibile schema in Fig. 4.

Fig. 3 – Esempio di interfaccia di controllo

Fig. 4 – Schema generale di un’interfaccia di controllo

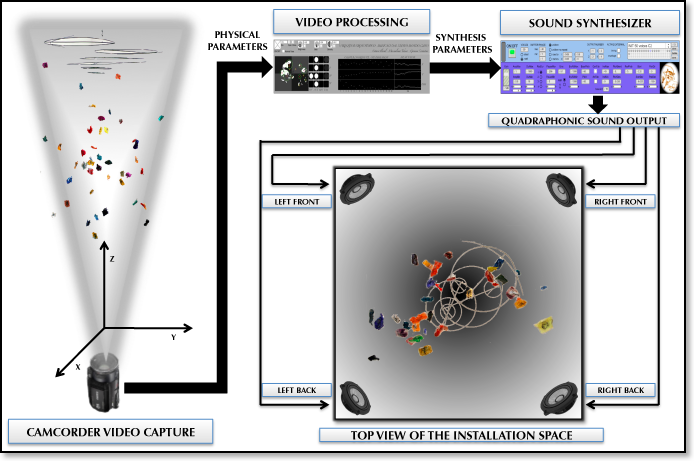

Una realizzazione di un sistema di questo tipo è data dall’installazione sonora Variazioni cronotopico-musicali da “Il nuovo mondo” (Fig. 5).

Fig. 5 – Schema dell’installazione sonora Variazioni cronotopico-musicali da “Il nuovo mondo”

L’opera, nata dalla scultura di Octavio Floreal “Il Nuovo Mondo”, ha conquistato a sé lo spazio ed il tempo, attraverso un’interazione video-musicale di Giovanni Costantini e Massimiliano Todisco.

Il processo di generazione sonora si basa sul sistema di sintesi granulare RandyMa ed è controllato in tempo reale dal movimento della scultura, rilevato da una videocamera e opportunamente elaborato da un computer.

È, quindi, la scultura stessa che crea la sua musica, attraverso combinazioni di altezze, timbri e ritmi.

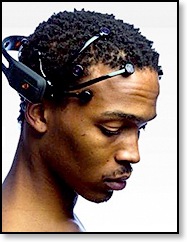

Interessanti, dal punto di vista del controllo, sono anche dispositivi di tipo Human Computer Interaction che fanno uso del Segnale Elettroencefalografico. Uno degli esempi più recenti, oggetto di studio e di applicazioni da parte di alcuni docenti del Master, è la EPOC neuroheadset (Fig. 6), in grado di fornire sia i segnali relativi alle onde cerebrali, sia segnali più ad alto livello, indicativi delle nostre emozioni.

Fig. 6 – EPOC neuroheadset

Negli ultimi anni, l’attenzione si è spostata su interfacce, denominate Human Body Tracking Interface, per la rilevazione del movimento del corpo umano e il riconoscimento dei gesti, attraverso sensori che possono rilevare oggetti in spazi tridimensionali.

Le Human Body Tracking Interface hanno applicazioni in molti campi, come, ad esempio, i videogiochi, la sorveglianza, la sanità e le arti visive e musicali. Esempi di tali applicazioni saranno oggetto di studio nei corsi di “Tecnologie e tecniche per il live electronics” e “Composizione di musica elettroacustica II”, nellaMasterclass tenuta dai Ricercatori dell’IRCAM (Parigi) e nella Masterclass Performing Arts tenuta da ricercatori di Università statunitensi.

Tra questo genere di sensori, va menzionata la Microsoft Kinect (Fig. 7), sia per la qualità raggiunta sia perché è oramai accessibile a tutti per i bassi costi di vendita.

Fig. 7 – Microsoft Kinect

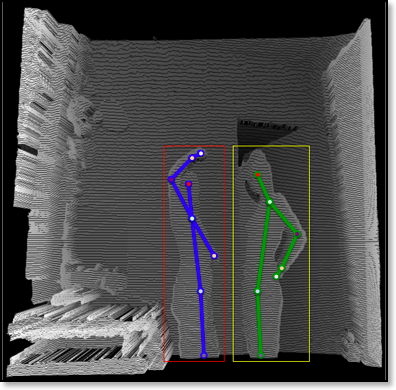

La Kinect riunisce, in un unico dispositivo, una telecamera RGB, un sensore di profondità basato su tecnologia a raggi infrarossi e un array microfonico: è quindi in grado di rilevare i movimenti del corpo, riconoscere gesti e rispondere a comandi vocali. In Fig. 8 è mostrata una nostra elaborazione del segnale video proveniente dalla Kinect, nella quale si possono distinguere chiaramente due corpi umani in movimento, evidenziati nei rettangoli rosso e giallo.

Fig. 8 – Elaborazione del segnale video proveniente dalla Kinect

Questi ed altri sensori saranno utilizzati, durante la stagione concertistica prevista fra marzo e luglio 2012, in performance artistiche che vedranno coinvolti suono, video, danza e recitazione. In quell’occasione gli studenti del Master, dopo la fase di studio durante il corso, potranno partecipare, in forma di stage, alla realizzazione di prodotti artistici completi.

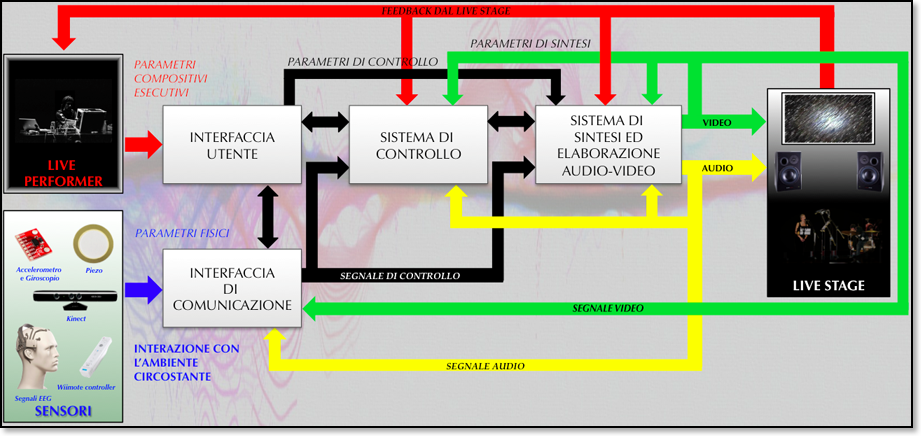

In conclusione, lo schema di Fig. 1 può essere generalizzato in quello di Fig. 9, nel caso in cui venga coinvolta anche la sintesi/elaborazione di un segnale video.

Fig. 9

Riferimenti

- G. Costantini, G. Saggio, M. Todisco, A Glove Based Adaptive Sensor Interface for Live Musical Performances, 1st SENSORDEVICES International Conference on Sensor Device Technologies and Applications, Venice, Italy, July 18-25, 2010.

- G. Costantini, M. Todisco, G. Saggio, A Cybernetic Glove to Control a Real Time Granular Sound Synthesis Process, IMCIC International Multi-Conference on Complexity, Informatics and Cybernetics, Orlando, Florida, USA, April 6-9, 2010.

- G. Costantini, M. Todisco, G. Saggio, A Wireless Glove to Perform Music in Real Time, 8th WSEAS International Conference on APPLIED ELECTROMAGNETICS, WIRELESS and OPTICAL COMMUNICATIONS, Penang, Malaysia, March 23-25, 2010.

- G. Costantini, M. Todisco, M. Carota, D. Casali, A New Physical Sensor Based on Neural Network for Musical Expressivity, Proceedings of the 13th AISEM Italian Conference Sensors and Microsystems, Rome, Italy, February 19-21, 2008, pp. 281-288.

- G. Costantini, M. Todisco, M. Carota, A Neural Network Based Interface to Real Time Control Musical Synthesis Processes, Proceedings of the 11th WSEAS International Conference on CIRCUITS, Agios Nikolaos, Crete Island, Greece, July 23-25, 2007, pp.41-45.

- G. Costantini, M. Todisco, M. Carota, G. Maccioni, D. Giansanti, A New Adaptive Sensor Interface for Composing and Performing Music in Real Time, Proc. of 2nd IEEE International Workshop on Advances in Sensors and Interfaces , 26-27 June 2007, Bari, Italy, pp.106-110.

- Bongers, B. 2000, Physical Interfaces in the Electronic Arts. Interaction Theory and Interfacing Techniques for Real-time Performance, In M. Wanderley and M. Battier, eds. Trends in Gestural Control of Music. Ircam – Centre Pompidou.

- Orio, N. 1999, A Model for Human-Computer Interaction Based on the Recognition of Musical Gestures, Proceedings of the 1999 IEEE International Conference on Systems, Man and Cybernetics, pp. 333-338.

- Abraham Moles, Information Theory and Aesthetic Perception, University Of Illinois Press (1969).

- Rudolf Arnheim, Entropy and Art: An Essay on Disorder and Order, University of California Press (January 29, 1974).

- Hertz J., A. Krogh & R.G. Palmer, Introduction to the theory of neural computation, Addison-Wesley Publishing Company, Reading Massachusetts, 1991.